Hauptinhalt

Philipps-Universität Marburg - Hochschulrechenzentrum

-

Foto: Kerstin Runzheimer

Foto: Kerstin Runzheimer

Willkommen im Hochschulrechenzentrum

Profil

Themen

-

Erste Schritte

Neu an der Uni? - Mit diesem Einstieg gelingt der Start

-

Dienste

Hier finden Sie einen Überblick über die Dienste des Hochschulrechenzentrums. Wenn Sie Ihr Thema nicht finden, schauen Sie auch in das A-Z Verzeichnis.

-

Direkt zu

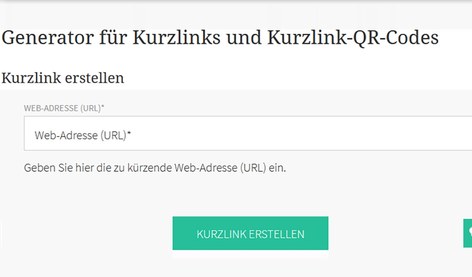

Links zu den Portalen für Zweifaktor-Authentisierung, Posterdruck, LIVE Support, Hessenbox, Mailinglistenverwaltung, URL Shortener, Planio, Videokonferenzen, ...

-

Hilfe & Beratung

Probleme melden, Ansprechpartner finden, Anleitungen und Formulare im Überblick und das HRZ von A-Z entdecken

-

Über uns

Erfahren Sie mehr über das HRZ - Profil, Projekte, Personal, Geschichte, Zahlen und das IT-Management der Universität

Zurückblättern

Vorblättern

-

Erste Schritte

Neu an der Uni? - Mit diesem Einstieg gelingt der Start

-

Dienste

Hier finden Sie einen Überblick über die Dienste des Hochschulrechenzentrums. Wenn Sie Ihr Thema nicht finden, schauen Sie auch in das A-Z Verzeichnis.

-

Direkt zu

Links zu den Portalen für Zweifaktor-Authentisierung, Posterdruck, LIVE Support, Hessenbox, Mailinglistenverwaltung, URL Shortener, Planio, Videokonferenzen, ...

-

Hilfe & Beratung

Probleme melden, Ansprechpartner finden, Anleitungen und Formulare im Überblick und das HRZ von A-Z entdecken

-

Über uns

Erfahren Sie mehr über das HRZ - Profil, Projekte, Personal, Geschichte, Zahlen und das IT-Management der Universität

Aktuelles

Nachrichten

Termine