28.09.2011

Gesichter erkennen wie ein Automat

Marburger Neurophysiker: Wie identifiziert das Hirn menschliche Züge?

Personen neigen zu denselben Fehlern wie spezialisierte Computerprogramme, wenn sie versuchen, Gesichter als solche zu erkennen. Das haben Neurophysiker von der Philipps-Universität herausgefunden, die ihre Ergebnisse in der aktuellen Ausgabe des Online-Wissenschaftsmagazins „PLoS One“ veröffentlichen, die demnächst erscheinen wird.

„In einer sozialen Umgebung ist es wichtig, Gesichtseindrücke zu verarbeiten, zum Beispiel, weil das Verhalten gegenüber anderen von deren Gefühlsäußerungen beeinflusst wird“, schreiben die Autoren um Bernard Marius 't Hart und Professor Dr. Wolfgang Einhäuser. Dazu passt, dass Gesichter schneller als solche erkannt werden als andere Objekte. Um menschliche Züge zu identifizieren, reichen offenbar relativ einfache Wahrnehmungsfilter aus, wie sie von den Zellen in der primären Sehrinde des Hirns zur Verfügung gestellt werden.

Die Marburger Wissenschaftler verglichen den Vorgang der Gesichtserkennung menschlicher Probanden mit Leistungen, die eine Gesichtserkennungssoftware erbringt. Solche Systeme sind mittlerweile dermaßen erfolgreich, dass sie sogar kommerziell verwertet werden. Trotzdem kommen Fehler vor. Täuschen Muster, die dabei fälschlicherweise als Gesichter identifiziert werden, auch menschliche Betrachter?

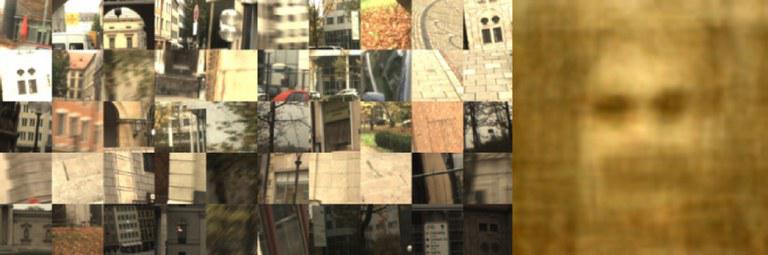

(Abbildung: AG Einhäuser)

Um diese Frage zu beantworten, konfrontierten die Forscher ihre Testpersonen wenige Millisekunden lang mit Bildpaaren, die jeweils ein Gesicht und ein anderes Objekt zeigten: Letzteres bestand entweder aus einem beliebigen Gegenstand, bei dem die Software korrekt erkannt hatte, dass es sich nicht um ein Gesicht handelt; oder aus einem "falsch-positiven" Muster, das maschinell fälschlicherweise als menschliches Antlitz identifiziert worden war. Die Probanden wurden in einem ersten Experiment gebeten, den Blick auf das Gesicht zu richten, wobei die Augenbewegung aufgezeichnet wurde. Dabei zeigte sich, dass die falsch-positiven Bilder häufiger mit Gesichtern verwechselt wurden als andere Muster – genau so, wie bei der maschinellen Gesichtserkennung.

Anders sah es in einem zweiten Experiment aus, bei dem die Testpersonen eine Taste drückten, wenn sie ein Gesicht zu erkennen glaubten. Hier waren Missgriffe nicht abhängig von der Zusammensetzung der Bildpaare; die falschen Zuschreibungen glichen in diesem Fall also nicht denen der Software.

„Unsere Ergebnisse deuten darauf hin, dass den Augenbewegungen eine schnelle, unbewusste Gesichtsdetektion zu Grunde liegt; beim Drücken der richtigen Taste greift dagegen wohl bereits ein anderer Prozess“, folgert Versuchsleiter Wolfgang Einhäuser. Bei der ersten, schnellen Verarbeitung kommen offenbar die gleichen Prinzipien zum Tragen wie bei einer Maschine.

Originalveröffentlichung: Bernard Marius 't Hart & al.: Faces in

places, PLoS One (2011), DOI: 10.1038/nphys2091;

URL:

http://dx.plos.org/10.1371/journal.pone.0025373

Weitere Informationen:

Ansprechpartner: Professor Dr. Wolfgang Einhäuser,

Arbeitsgruppe Neurophysik

Tel.: 06421 28-

24164

E-Mail:

wet@physik.uni-marburg.de

Bernard Marius 't Hart

Tel.: 06421 28-24176

E-Mail:

thart@staff.uni-marburg.de