Themen

-

Fachbereich

Organisation, Personen, Verwaltung, Selbstverwaltung, Infrastruktur, Geschichte... -

Studium

Alles rings ums Studium - Informationen für Studierende und für Studieninteressierte... -

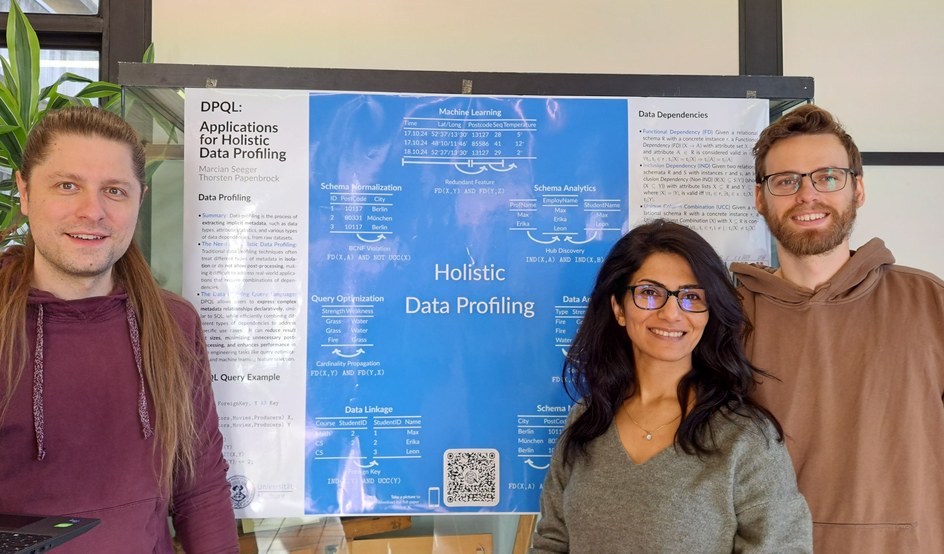

Forschung

Anwendungsbezogene & theoretische Forschung, fachspezifische & interdisziplinäre Projekte, uni-weite & -übergreifende Kooperationen... -

Arbeitsgruppen

Die Professorinnen und Professoren, ihre Arbeitsgruppen, Kooperationen und Arbeitsgebiete...

-

Fachbereich

Organisation, Personen, Verwaltung, Selbstverwaltung, Infrastruktur, Geschichte... -

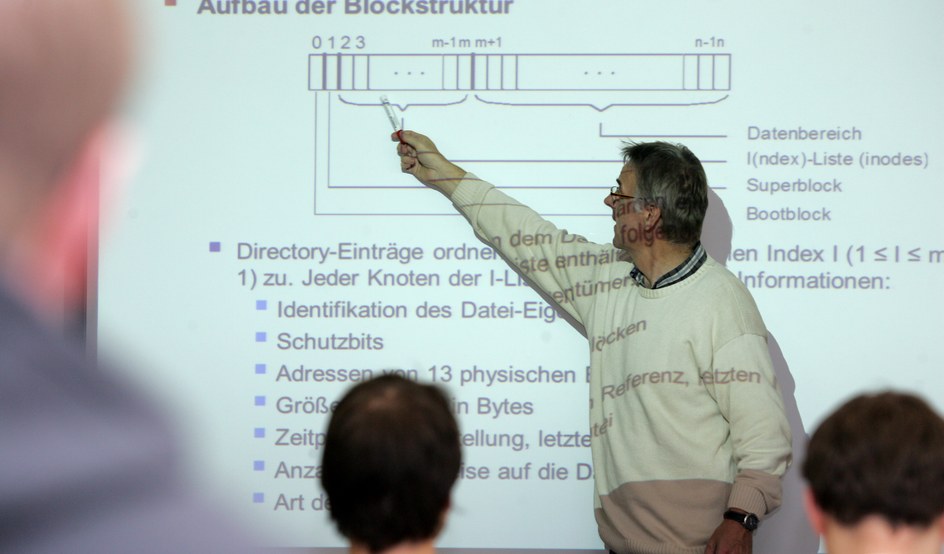

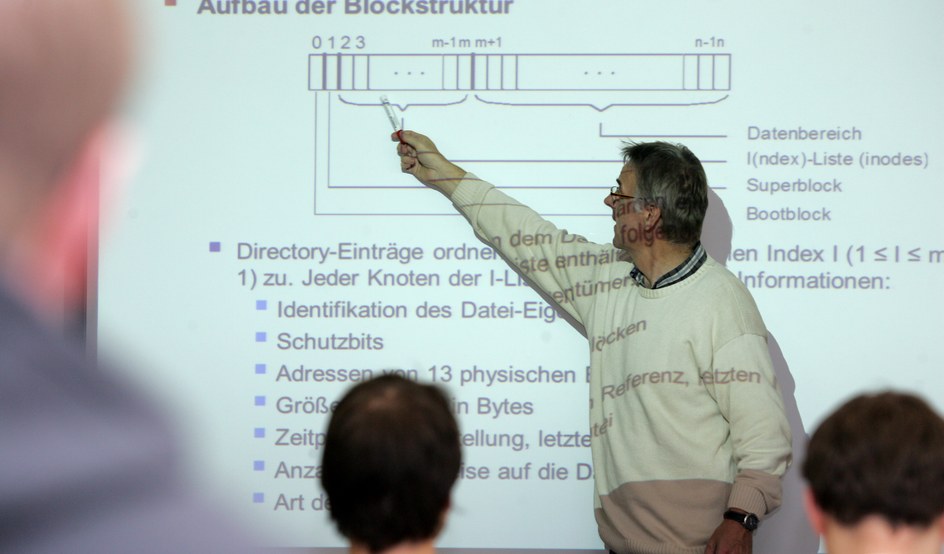

Studium

Alles rings ums Studium - Informationen für Studierende und für Studieninteressierte... -

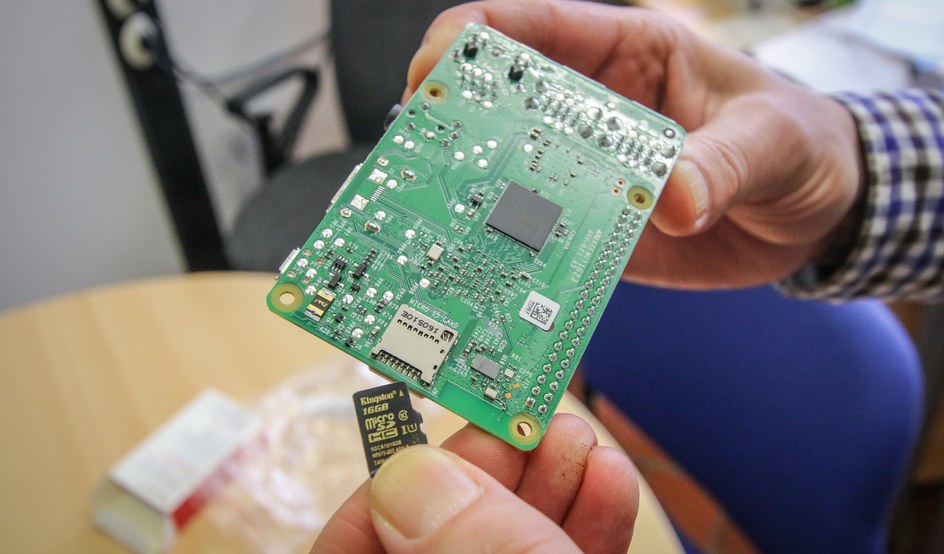

Forschung

Anwendungsbezogene & theoretische Forschung, fachspezifische & interdisziplinäre Projekte, uni-weite & -übergreifende Kooperationen... -

Arbeitsgruppen

Die Professorinnen und Professoren, ihre Arbeitsgruppen, Kooperationen und Arbeitsgebiete...